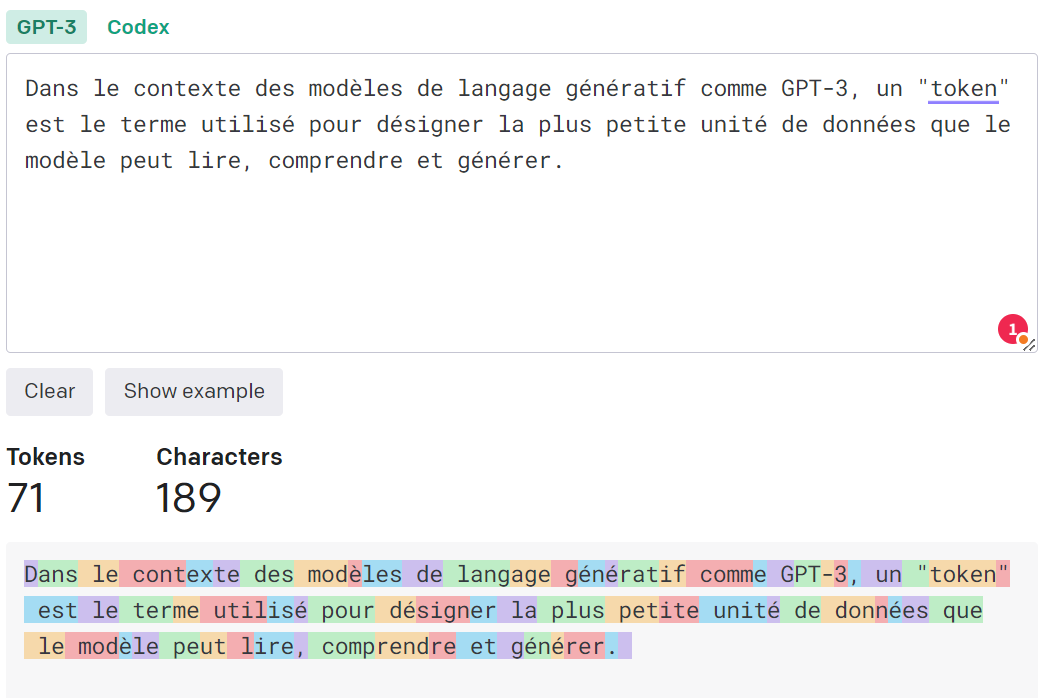

Dans le contexte des modèles de langage génératif comme GPT-3, un « token » est le terme utilisé pour désigner la plus petite unité de données que le modèle peut lire, comprendre et générer.

Un token peut être aussi petit qu’un seul caractère ou aussi grand qu’un mot entier, ou même une entité plus grande dans certaines langues. Le choix de la taille d’un token dépend du modèle spécifique et de la façon dont il a été formé.

Par exemple, dans le cas de GPT-3, un token est généralement un mot ou une partie d’un mot. Si vous donnez à GPT-3 une phrase à générer, elle va la décomposer en tokens (mots ou parties de mots), puis utiliser ces tokens pour prédire et générer la suite du texte.

Pour comprendre plus en profondeur, nous pouvons considérer le processus de tokenisation. La tokenisation est la première étape de l’entraînement d’un modèle de langage génératif. Pendant la tokenisation, le texte est divisé en morceaux, ou « tokens ». Ces tokens sont ensuite utilisés pour former le modèle sur la façon dont les mots (ou les parties de mots) s’associent les uns aux autres pour former des phrases et des idées.

Par exemple, considérez la phrase « J’aime le SEO ». Dans ce cas, un modèle pourrait tokeniser cette phrase en quatre tokens : [« J' », « aime », « le », « SEO »]. Chaque token est traité séparément par le modèle lors de l’apprentissage et de la génération de texte.

Il est important de noter que la définition exacte de ce qui constitue un « token » peut varier en fonction du modèle et de la langue. Dans certaines langues, comme le chinois, où les mots ne sont pas séparés par des espaces, un token pourrait être un seul caractère. Dans d’autres cas, comme avec certains modèles de langage génératif, un token pourrait être une séquence plus longue de mots ou de caractères.

La manière dont les tokens sont définis et utilisés a un impact significatif sur la façon dont le modèle apprend et génère du texte. Les tokens aident le modèle à comprendre le contexte, la grammaire, et même le ton ou le style d’un texte.

Ce contenu vous a plu ?

Inscrivez-vous gratuitement à notre newsletter et recevez chaque semaine l’actualité du SEO directement dans votre boîte email. Vous pouvez vous désabonner à tout moment !