L’évaluation de la qualité d’un contenu SEO devient de plus en plus complexe à mesure que les sites grandissent et que la concurrence s’intensifie. À grande échelle, il est difficile de passer manuellement en revue chaque article, page ou publication pour juger de sa pertinence et de sa performance. Grâce aux avancées de l’intelligence artificielle (IA) et du traitement du langage naturel (NLP), il est désormais possible d’automatiser et d’objectiver ce processus d’évaluation.

Comprendre la notion de qualité SEO

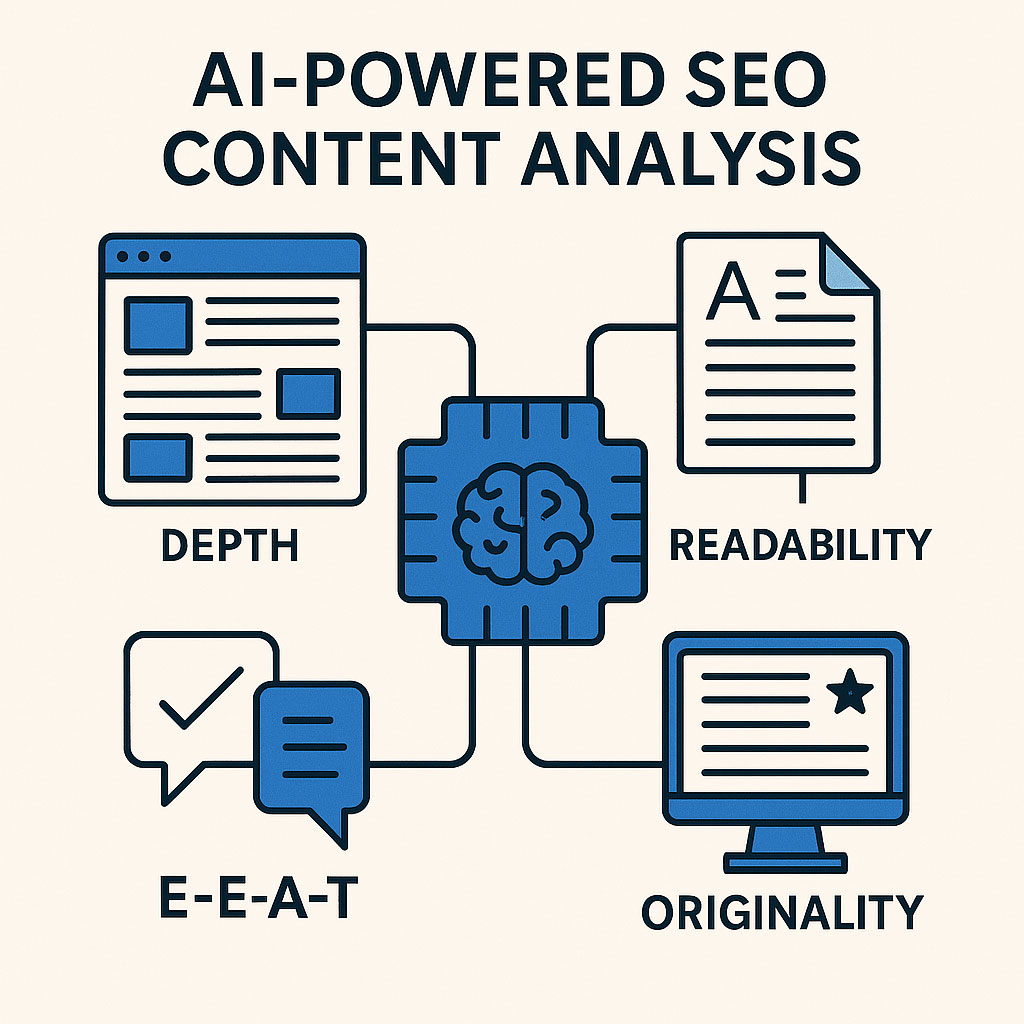

Lorsqu’on parle de « qualité » pour un contenu SEO, on dépasse le simple critère du mot-clé placé au bon endroit. La qualité SEO se définit par sa capacité à répondre à l’intention de recherche, à fournir une expérience utilisateur satisfaisante et à respecter les directives des moteurs de recherche. Dans ce cadre, Google a introduit le concept de E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness), qui renforce l’idée que le contenu doit faire preuve de fiabilité, de légitimité, tout en étant utile et aligné sur les attentes des internautes.

Il est également important de noter que la qualité SEO se reflète dans divers signaux, comme la profondeur sémantique d’un texte, l’originalité, la lisibilité, la structure (Hn, balises et paragraphes) et la cohérence globale du message. La difficulté, quand on gère un grand parc de contenus (blogs, fiches produits, guides, pages d’information), réside dans l’évaluation simultanée de ces paramètres sur des dizaines, voire des centaines de milliers de pages.

Les principales métriques à surveiller

Dans une démarche d’évaluation à grande échelle, l’objectif est de définir un ensemble de métriques permettant de quantifier la qualité du contenu. Parmi ces indicateurs, on peut citer :

- Profondeur sémantique : mesure la richesse du vocabulaire et des champs lexicaux liés au sujet traité.

- Lisibilité : évalue la facilité de lecture (longueur des phrases, vocabulaire, clarté de la syntaxe) via des indices comme le Flesch Reading Ease.

- E-E-A-T : vérifie la présence de signaux de confiance (auteur identifiable, mentions de sources, retours d’expérience concrets) et d’expertise.

- Originalité : détecte la duplication ou la paraphrase excessive, assurant que le contenu soit unique.

- Structure Hn et mise en forme : vérifie la hiérarchie des balises de titre, la présence de paragraphes, d’images ou d’éléments de réassurance.

Il existe évidemment d’autres signaux, comme la pertinence du champ lexical utilisé ou la densité en mots-clés, mais il faut veiller à ne pas se limiter à des critères strictement quantitatifs : la dimension qualitative d’un texte reste primordiale.

Tirer parti des modèles NLP pour automatiser l’analyse

Avec l’avènement des modèles de traitement du langage naturel (NLP), il est possible d’analyser la sémantique et la structure d’un texte sans intervention humaine directe. Des bibliothèques comme SpaCy, NLTK ou Transformers (BERT, GPT) permettent d’extraire des entités nommées, de calculer la similarité sémantique entre des termes et de repérer les champs lexicaux couverts par un texte.

Pour évaluer la qualité d’un contenu, on peut par exemple :

- Analyser la couverture sémantique : comparer le texte à un corpus de référence pour voir s’il inclut les éléments essentiels.

- Mesurer la diversité lexicale : déterminer si le texte utilise un vocabulaire varié ou répète mécaniquement les mêmes mots-clés.

- Estimer la cohérence : vérifier si le texte s’organise autour d’un sujet clair et ne dérive pas vers des informations hors sujet.

Ces approches reposent souvent sur des modèles de vectorisation (Word2Vec, GloVe, BERT) qui traduisent les mots et les phrases en vecteurs numériques pour mesurer les similarités.

Voici un code exemple en Python qui permet de mesurer la diversité lexicale et estimer la cohérence

import spacy

from sklearn.metrics.pairwise import cosine_similarity

import numpy as np

# Exemple : modèle français (assurez-vous de l'avoir téléchargé)

nlp = spacy.load("fr_core_news_sm")

texte = """Votre texte ici. Votre texte ici. ..."""

# 1) Tokenisation, suppression des stopwords

doc = nlp(texte)

tokens = [token.lemma_.lower() for token in doc if token.is_alpha and not token.is_stop]

# 2) Diversité lexicale (TTR)

nb_tokens = len(tokens)

nb_types = len(set(tokens))

ttr = nb_types / nb_tokens if nb_tokens != 0 else 0

print("TTR :", round(ttr, 3))

# 3) Cohérence (exemple basique via similarité inter-paragraphes)

paragraphes = texte.split("\n\n") # scission par double saut de ligne

vecs = []

for p in paragraphes:

p_doc = nlp(p)

# Récupère un embedding "moyen" des vecteurs token

vecs.append(p_doc.vector)

if len(vecs) > 1:

# Calcul de similarité moyenne

sim_matrix = cosine_similarity(vecs)

# On peut extraire la moyenne hors diagonale

# np.triu_indices pour la partie triangulaire supérieure, hors diagonale

tri_upper = np.triu_indices(len(vecs), k=1)

mean_sim = np.mean(sim_matrix[tri_upper])

print("Similarité moyenne inter-paragraphes :", round(mean_sim, 3))

else:

print("Texte trop court pour une analyse de cohérence par paragraphes.")

Points clés de cet exemple

- TTR (Type-Token Ratio) pour évaluer la diversité lexicale.

- Similarité inter-paragraphes pour une vision rapide de la cohérence :

- Plus les paragraphes sont similaires, plus le texte est monotone (ou cohérent, selon le contexte).

- Un écart trop important peut signaler un hors-sujet ou une thématique totalement différente.

Exemple de rendu

TTR : 0.901

Similarité moyenne inter-paragraphes : 0.775

Comment interpréter ce résultat pour l’exemple de texte que nous avons utilisé ?

Voici quelques pistes d’interprétation pour ces deux indicateurs, dans le cadre d’une analyse de la qualité du contenu (en tenant compte des limites d’une simple métrique chiffrée, évidemment) :

1. TTR (Type-Token Ratio) à 0,901

- Qu’est-ce que ça mesure ?

Le TTR est le rapport entre le nombre de mots distincts (types) et le nombre total de mots (tokens). TTR=nombre de mots distincts/nombre total de mots - Comment lire cette valeur ?

- 0,901 est un TTR très élevé, indiquant une forte diversité lexicale.

- Autrement dit, il y a très peu de répétitions dans le texte : pour 100 mots, ~90 sont uniques (en tenant compte, dans cet exemple, de la lemmatisation et du nettoyage de stopwords).

- Un TTR proche de 1 signifierait que quasiment chaque mot est unique, ce qui est rare dans des textes longs.

- À l’inverse, un TTR proche de 0,5 ou moins indiquerait davantage de redondance dans le vocabulaire.

Interprétation générale

- Richesse lexicale : le texte paraît riche, varié dans son vocabulaire, ce qui est en général perçu positivement (notamment pour éviter une “bourrinade” de mots-clés en SEO).

- Risques potentiels :

- Si ce TTR a été calculé sur un texte plutôt court, il se peut qu’une partie de cette valeur élevée vienne simplement du fait que le texte n’a pas assez de volume pour présenter des récurrences lexicales “normales”.

- Sur un texte plus long, 0,90+ est vraiment très haut et laisse supposer un champ lexical particulièrement large (ou un contenu assez hétérogène).

2. Similarité moyenne inter-paragraphes à 0,775

- Qu’est-ce que ça mesure ?

- Chaque paragraphe est converti en un vecteur (embedding), puis on calcule la similarité cosinus pour quantifier la proximité sémantique entre les paragraphes.

- La valeur 0,775 correspond à la moyenne des similarités entre tous les couples de paragraphes (hors diagonale).

- Comment lire cette valeur ?

- La similarité cosinus varie entre 0 (aucune similarité) et 1 (similaires au point d’être quasiment identiques).

- 0,775 est relativement élevé : cela signifie que les paragraphes partagent un important fonds sémantique commun.

Interprétation générale

- Cohérence :

- Un score proche de 1 impliquerait des paragraphes quasi “répétitifs” ou très similaires.

- Un score moyen autour de 0,7–0,8 suggère qu’ils traitent un sujet commun tout en ayant quelques nuances lexicales ou informatives.

- Un score < 0,5 signifierait qu’on a des paragraphes nettement différents, voire hors sujet les uns par rapport aux autres.

- Équilibre :

- 0,775 peut être le signe d’une bonne cohérence globale : les paragraphes ne sont pas identiques mot pour mot, mais ils abordent certainement un thème central commun.

- Si on souhaitait des paragraphes plus variés (par exemple dans un contenu encyclopédique couvrant plusieurs aspects d’un sujet), on pourrait estimer qu’une similarité un peu plus basse serait souhaitable. À l’inverse, pour un texte qui doit rester très ciblé (un guide précis sur un sujet unique), un score élevé est positif.

3. Synthèse globale

- TTR ≈ 0,90

- Indique un vocabulaire très riche et peu répétitif. Pour un texte d’une certaine longueur, c’est souvent positif d’un point de vue éditorial : cela évite la monotonie et la “sur-optimisation” de mots-clés.

- Attention simplement à ne pas trop “diluer” le message principal si le texte devient trop dispersé lexicalement.

- Similarité inter-paragraphes ≈ 0,775

- L’ensemble des paragraphes se situe sur la même ligne directrice.

- Il n’y a pas de rupture de thème trop importante.

- Le texte semble globalement cohérent, tout en laissant place à une certaine variété (puisqu’on n’est pas collé à 1).

Conclusion pratique

- Qualité potentielle : le texte a l’air d’aborder un sujet principal de manière relativement approfondie et diversifiée, sans être répétitif.

- Points de vigilance :

- La taille du texte : ces valeurs n’ont pas la même portée si le texte fait 200 mots vs. 2 000 mots.

- Le degré de “digression” : une TTR trop élevée pourrait aussi refléter un contenu un peu trop “fourre-tout”.

- La cohérence attendue : si l’objectif est de couvrir plusieurs sujets connexes, le taux de similarité est correct. S’il s’agit d’un texte très spécialisé sur un seul point, on pourrait encore monter en similarité.

En somme, un TTR élevé et une similarité inter-paragraphes modérément haute (environ 0,775) traduisent un contenu à la fois varié lexicalement et cohérent sur le plan thématique, ce qui est le plus souvent un bon signe pour la qualité rédactionnelle et la pertinence sémantique.

Ouf puisqu’il s’agit d’un broullon de cet article que nous avons utilisé pour le test !

Mettre en place un scoring pondéré

Pour exploiter pleinement les analyses NLP, il convient de bâtir un score d’évaluation global, pondérant chaque métrique selon son importance. Par exemple, on peut accorder :

- 30 % à la pertinence sémantique (couvrant la diversité lexicale, la cohérence et l’alignement sur le sujet)

- 20 % à la lisibilité (indices de lecture, longueur des phrases, syntaxe)

- 20 % à l’E-E-A-T (critères de crédibilité, mentions de sources, author box)

- 20 % à l’originalité (taux de duplication, vérification anti-plagiat)

- 10 % à la structure (bonne hiérarchie Hn, formats multisupports, etc.)

Ces pondérations varient selon la nature du site (e-commerce, blog d’expertise, portail d’information, etc.). Pour un e-commerce, la pertinence sémantique et la qualité descriptive (structure, photos, attributs produits) pourront être plus valorisées. Pour un blog santé, l’E-E-A-T sera davantage déterminant.

Limites et meilleures pratiques

L’évaluation automatisée par l’IA ne remplace pas totalement l’expertise humaine. Les algorithmes d’analyse sémantique peuvent se tromper, notamment sur les sujets complexes, et ils ne peuvent juger la pertinence d’un angle éditorial ou l’émotion suscitée par un texte. Il est donc recommandé de combiner un audit automatisé avec un échantillonnage de vérifications manuelles afin d’affiner les scores et de repérer d’éventuelles anomalies.

De plus, la mise en place de cette automatisation nécessite un certain budget et des compétences techniques (développement Python, connaissance des modèles NLP, configuration de pipelines de traitement). Les gains en efficacité et en cohérence éditoriale compensent toutefois très largement l’investissement initial, surtout lorsque la taille du site ou l’ampleur du catalogue de contenus dépassent plusieurs milliers de pages.

Évaluer la qualité SEO d’un large ensemble de contenus requiert des méthodes à la fois sophistiquées et pragmatiques. L’IA, couplée à des outils de NLP, permet de définir et de calculer rapidement des métriques objectives telles que la diversité lexicale, la cohérence sémantique, la lisibilité et l’originalité. En pondérant ces facteurs pour établir un score global, il devient possible d’identifier les pages faibles, les contenus obsolètes ou dupliqués, et de prioriser les améliorations.

Malgré tout, l’intervention humaine reste cruciale pour valider et affiner les conclusions algorithmiques. En combinant l’IA et l’expertise d’un rédacteur ou d’un consultant SEO, on parvient à un diagnostic solide, permettant de maintenir ou d’améliorer la qualité globale d’un site. À l’heure où la concurrence se joue autant sur la pertinence et l’expérience utilisateur que sur la technique, adopter une démarche data-driven et scalable est un avantage compétitif majeur. N’attendez donc pas pour déployer ces solutions et faire entrer votre stratégie de contenu dans une nouvelle ère, orientée performance et pertinence.

Ce contenu vous a plu ?

Inscrivez-vous gratuitement à notre newsletter et recevez chaque semaine l’actualité du SEO directement dans votre boîte email. Vous pouvez vous désabonner à tout moment !