Neper accompagne de plus en plus de sites de medias et leurs journalistes dans l’optimisation de leur contenu pour Google Search, News et bien sur Discover.

Et on nous pose souvent la question : l’IA va-t’elle révolutionner le travail des journalistes ?

La réponse est oui. Les usages de l’IA sont déjà en train de percoler dans tout le processus de création de contenu, depuis l’idéation jusqu’à la rédaction ou l’analyse des résultats.

Mais les types d’IA qui sont utiles dans les entreprises de presse sont beaucoup plus variés que les IA génératives comme ChatGPT, Claude, Llama Mistral ou Gemini.

Pour les IA générative, deux études montrent que ce n’est pas encore demain que ces outils vont remplacer les journalistes.

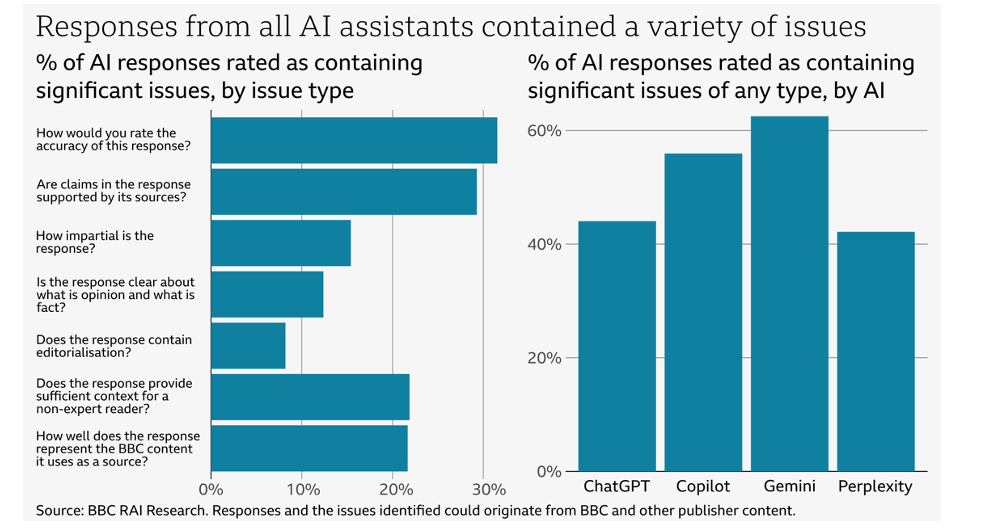

51% des contenus générés par une IA générative à partir des actualités de la BBC présentent un sérieux problème

En mars 2025, la BBC a publié une étude sur la fiabilité des informations produites par les IA génératives sur des sujets d’actualité. Le prompt utilisé forçait les IA à fonctionner en mode RAG, et à aller chercher les infos non pas dans les infos de leur modèle mais dans des articles d’actualités du site de la BBC.

Vous trouverez l’étude complète ici :

https://www.bbc.co.uk/aboutthebbc/documents/bbc-research-into-ai-assistants.pdf

Parmi les informations saillantes, on voit que 31% des pages générées contiennent des erreurs factuelles. C’est un chiffre en progression, mais 31% c’est encore beaucoup trop pour qu’un media sérieux laisse une IA générative créer des articles de presse sans supervision.

51% des contenus contiennent un problème qualifié de « sérieux », et 91% des contenus contiennent au moins un problème de qualité.

Parmi les problèmes recensés:

- les contenus sont mal sourcés : souvent, l’origine des informations n’est pas identifiable

- quand il y’a une source, celle-ci ne confirme pas forcément les informations relatées

- le contenu introduit souvent une forme de partialité dans la présentation des faits

- il est fréquent de voir de l’éditorialisation, c’est à dire des propos d’éditorialistes (donc des contenus qui expriment une opinion, comme dans un éditorial) là où on veut des contenus neutres.

- en outre, les contenus ne précisent pas clairement ce qui relève du fait et de ce qui relève de l’opinion

- il n’y a pas de mise en contexte, comme dans un bon papier de journaliste

- et (sacrilège à la BBC) le contenu produit est trop différent de la charte éditoriale de la BBC

L’étude montre que ces défauts sont répartis différemment entre les IA génératives testées (Perplexity, Gemini, Copilot et ChatGPT). Mais aucun outil ne passe ces tests « haut la main ».

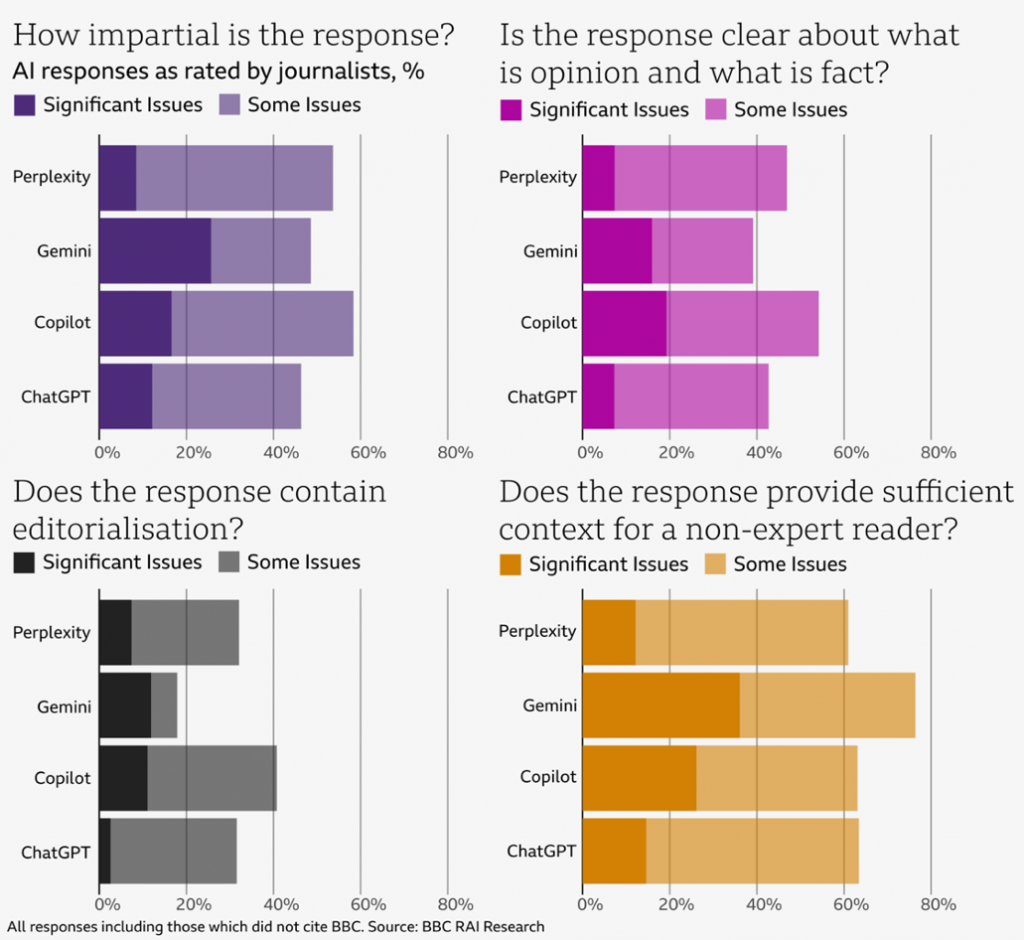

Les limites des IA génératives pour rédiger des articles de presse vont au bien au dela de l’exactitude des faits rapportés

L’étude met en valeur plusieurs problèmes que les utilisateurs des IA génératives sont peu nombreux à remarquer : il n’y a pas que les erreurs factuelles qu’il faut corriger dans ce qui est produit par une IA.

Ces outils sont aujourd’hui très mauvais dans leur capacité à sourcer leurs informations. Et ils ont une tendance très forte à introduire des problèmes de partialité dans leur présentation des faits.

Dans ces deux domaines, les outils d’IA génératives font des progrès. Mais aujourd’hui, les utiliser demande aux journalistes de devoir non seulement corriger des erreurs factuelles, mais aussi de réécrire des paragraphes entiers pour rendre les articles plus neutres, mieux contextualisés et distinguant clairement ce qui relève de l’opinion du reste.

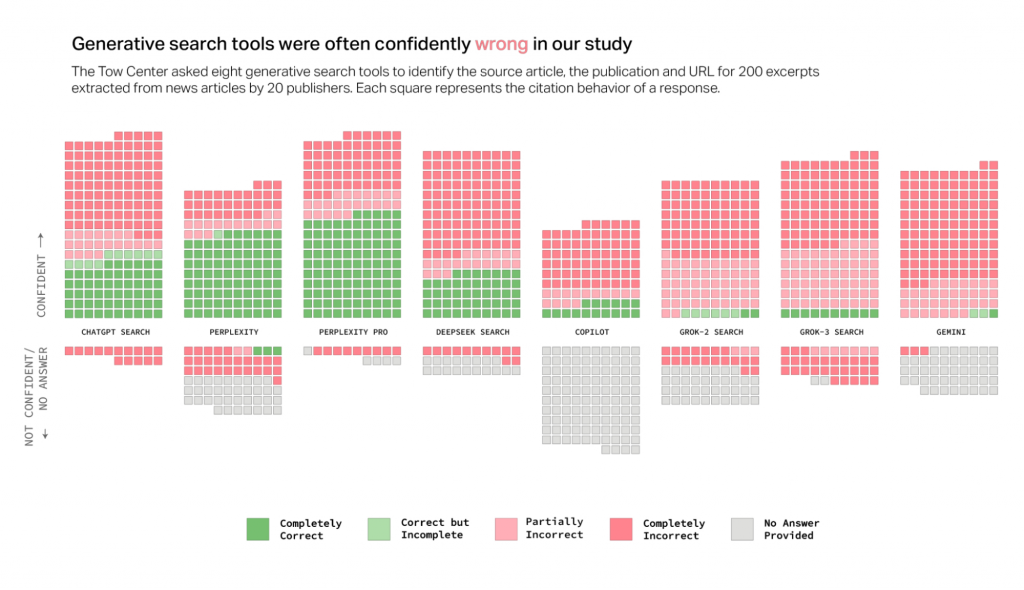

Un autre problème a été identifié par une étude de la revue américaine Columbia Journalism Review

Dans cette étude américaine : https://www.cjr.org/tow_center/we-compared-eight-ai-search-engines-theyre-all-bad-at-citing-news.php

8 outils d’IA générative ont été évalués pour savoir s’ils étaient capables de retrouver une source correctement à partir d’un extrait d’un article. Les résultats sont assez catastrophiques.

En moyenne, ces outils en mode RAG sont incapables d’identifer la page source dans 60% des cas, alors qu’on la trouve dans le top 3 des résultats de Google quand on tape l’extrait.

Ces résultats ont été souvent commentés dans la presse spécialisée en indiquant que les IA Génératives se trompaient dans 60% des cas. Non, ce n’est pas à ce point. Le problème c’est leur incapacité à retrouver et citer des sources sans erreur !

Un exemple de commentaire un peu rapide sur cette étude de la CJR

Est-ce que cela veut dire que les IA génératives ne peuvent pas servir pour rédiger du contenu pour la presse ?

Si on considère l’état de l’art actuel, la réponse est oui : on ne peut pas utiliser d’IA génératives dans l’usage commun qui en est fait aujourd’hui et atteindre les standards exigés dans les sites de presse.

Est-ce que les IA Génératives vont s’améliorer suffisamment demain pour pouvoir atteindre ces standards ? Je pense que les outils peuvent faire beaucoup mieux que s’approcher de ces standards. Mais je suis encore sceptique sur la possibilité d’y parvenir sans aucune supervision humaine.

Le problème provient de la conception même des LLMs comme ChatGPT ou Gemini. On peut limiter drastiquement leur tendance à halluciner, et à inventer des informations. On peut leur apprendre à contextualiser, et à écrire de « bons papiers » journalistiques.

Mais il sera compliqué avec les approches actuelles de leur apprendre à distinguer le vrai du faux, à identifier les erreurs dans les sources pour ne pas les reprendre. Et surtout, à identifier dans les sources ce qui relève de l’opinion et des faits.

La necessité de réintroduire une approche déterministe dans le contexte des medias

Heureusement, il existe d’autres approches de Génération de Langage Naturel (NLG) qui combinent des logiques de « grammaires » et de l’IA générative pour commenter des faits avec une meilleure maîtrise du résultat.

Les approches déterministes ont été un peu « disqualifiées » dans un premier temps par le succès populaire des IA génératives. Pour les SEOs, on peut décrire ces outils comme du « content spinning » mais sous stéroïdes, avec une capacité à intégrer des centaines voire des milliers de règles complexes pour générer du contenu.

L’intérêt pour des méthodes de NLG Déterministes revient, même si elles sont moins faciles d’accès que les méthodes probilistes (GPT, Mistral, Claude, Gemini, Copilot etc…).

En clair, l’avenir semble être plutôt une approche hybride, qui combine les outils probabilistes là où la contrainte est faible, et où a besoin de diversité / « créativité », et les outils déterministes, là ou a besoin d’exactitude et de contrôle.

Les IA génératives d’aujourd’hui ne ressembleront donc probablement pas du tout à celles de demain.

Ce contenu vous a plu ?

Inscrivez-vous gratuitement à notre newsletter et recevez chaque semaine l’actualité du SEO directement dans votre boîte email. Vous pouvez vous désabonner à tout moment !