Google a annoncé hier le déploiement de deux nouvelles fonctionnalités à base d’IA sur les versions les plus avancées d’Android. Elles s’appuient sur les possibilités multimodales de leurs modèles d’IA, mais aussi sur des améliorations d’interface.

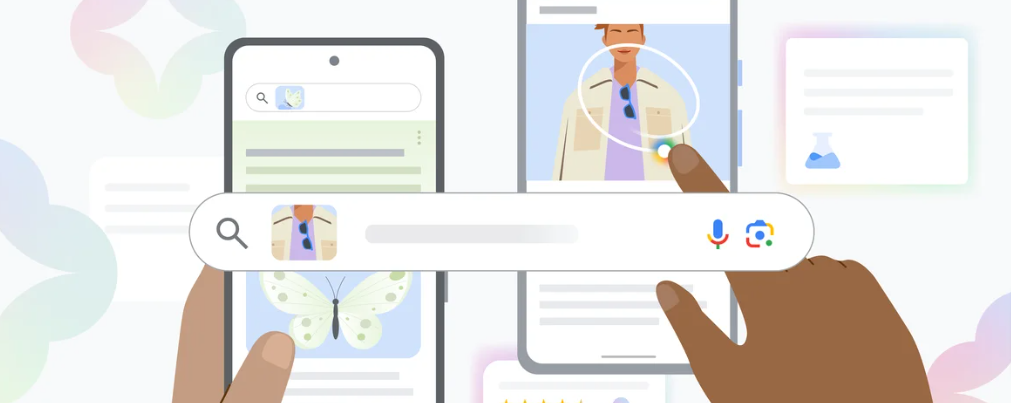

Circle to search

La première fonctionnalité sera déployée à partir du 31 janvier sur certains téléphones uniquement (les modèles les plus puissants et les plus récents tournant sur Android, à savoir le Pixel 8, le Pixel 8 Pro and les téléphones Samsung Galaxy de la série S24.

Elle permet de faire une recherche tout simplement en encerclant une zone d’une image ou d’un texte avec le doigt.

Comme indiqué sur la vidéo ci-dessus, cela fonctionne avec différentes approches pour sélectionner une zone de l’image : on peut l’encercler, la surligner, griffoner par dessus ou définir une zone avec deux doigts. Pour déclencher « Circle to Search », il suffit d’appuyer de manière prolongée sur le bouton d’accueil ou sur la barre de navigation de votre téléphone Android.

Cette fonction permet de lancer une recherche depuis n’importe quelle application, qu’elle soit d’origine Google ou non, sans vraiment sortir de l’application que vous consultez. Le gain de temps et de confort est évidemment très appréciable.

Il s’agit d’une des premières véritables implémentations universelles des possibilités multimodales des modèles de langue de Google, comme MUM et Gemini.

Si la fonctionnalité est limitée à certains appareils, elle sera par contre déployée partout dans le monde à la fin du mois de janvier.

La nouvelle expérience Multisearch

Le concept de Multisearch était apparu dans Lens en 2022. Mais jusqu’ici, ce que proposait Lens était essentiellement des résultats basés sur une certaine similarité visuelle.

Depuis le 17 janvier, si vous utilisez Lens (en prenant une photo ou en uploadant une image) afin d’effectuer une recherche, l’application Google utilisera une recherche multimodale beaucoup plus avancé pour vous renvoyer les types de résultats les plus pertinents, qu’il s’agisse d’images ou non.

Ces nouveaux « aperçus multimodaux », font là aussi appel aux modèles avancés de langage à base d’IA de Google.

Cette fonctionnalité est disponible sur l’appli Google aux USA entièrement à partir de maintenant. Pour les autres pays, elle n’est disponible que pour les utilisateurs inscrits à la SGE (donc pas en France), et à condition d’avoir switché sur la SGE.

Pour en savoir plus :

https://blog.google/products/search/google-search-ai-january-2024-update/

Ce contenu vous a plu ?

Inscrivez-vous gratuitement à notre newsletter et recevez chaque semaine l’actualité du SEO directement dans votre boîte email. Vous pouvez vous désabonner à tout moment !