Nouvelle fonctionnalité dans les paramètres de la GSC : dorénavant les webmasters pourront mieux comprendre et gérer l’indexation de leurs sites. Mais Google supprime dans un mois l’outil de test du fichier robots.txt …

Nouveau rapport disponible

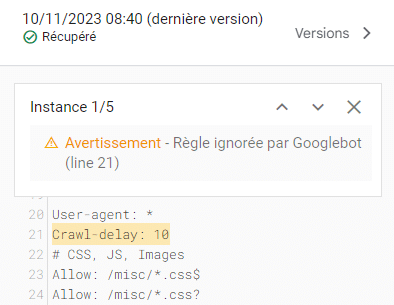

Ce nouvel outil indique les fichiers robots.txt trouvés par Google pour les 20 principaux hôtes de votre site, la dernière fois qu’ils ont été explorés et les éventuels avertissements ou erreurs rencontrés.

L’annonce a été faite le 15 novembre sur le compte X de la GSC :

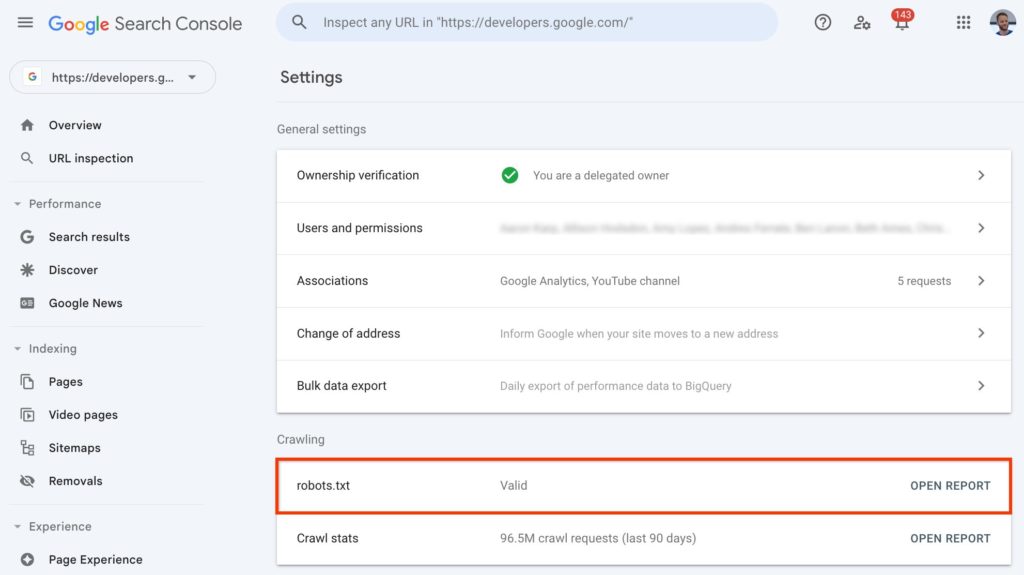

Ce nouveau rapport est disponible dans le monde entier, vous pouvez donc tout de suite aller le consulter via votre compte Google Search Console. Il vous suffit de vous rendre dans les paramètres dans la colonne de gauche et de cliquer sur « Ouvrir le rapport » ? Dès cette première étape vous pouvez savoir si votre robots.txt est valide ou si des « erreurs critiques » sont présentes.

Ce qui est intéressant ensuite, c’est de cliquer sur vos différents robots. Car même dans le cas ou votre robots.txt est valide et récupéré, il peut exister différents avertissements. C’est-à-dire les règles que Googlebot ignore malgré le fait qu’elles soient inscrites dans votre robots.txt.

Une bonne occasion de vous repartager le lien la page Help Center concernant le robots.txt : https://support.google.com/webmasters/answer/6062598

Suppression de l’ancien testeur Robots.txt

Souvent quand quelque chose apparait, malheureusement (ou heureusement cela est très personnel) quelque chose disparait.

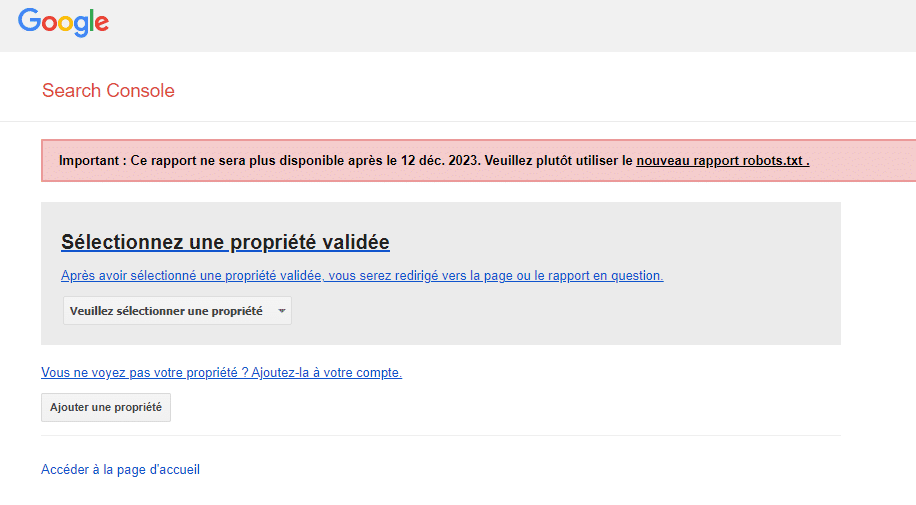

Par conséquent dès le 12 décembre 2023, l’outil de test du fichier robots.txt va être supprimé ! Vous n’y aurez plus accès. Pour rappel, ce testeur permettait de savoir si le fichier robots.txt empêchait les robots.txt d’explorer des urls spécifiques.

Sur X, les réactions sont plutôt variées ! La plupart du temps, les internautes sont contents d’avoir ce nouvel outil mais se demandent en revanche pourquoi supprimer l’ancien ?!

Ce contenu vous a plu ?

Inscrivez-vous gratuitement à notre newsletter et recevez chaque semaine l’actualité du SEO directement dans votre boîte email. Vous pouvez vous désabonner à tout moment !