BERT est une méthode d’analyse des textes qui permet de convertir les termes en coordonnées dans un « espace sémantique » virtuel. BERT a de nombreuses applications en traitement automatisé du langage, et notamment au sein des moteurs de recherche, jusque dans l’algorithme de Google. C’est cet outil qui est à l’oeuvre aujourd’hui dans l’identification des contenus proposés comme réponse sur les featured snippets. BERT (en fait une variante) est également exploité pour les fonctionnalités subtopics ranking (cf l’article de la semaine dernière) et le ranking des passages.

En fait, les techniques exploitant le machine learning et l’IA pour des applications de TALN connaissent un développement foisonnant. C’est justement le domaine de recherche que nous étudions avec Halaleh Kamari dans les Neperian Labs. BERT est en fait une technologie qui a engendré de nombreux avatars : CamemBERT le bien nommé (c’est la version française de BERT), FlauBERT (une autre version de BERT spécialisée dans le français), RoBERT, mais aussi USE, RoBERTa, XLNet, MT-DNN, SpanBERT, VisualBERT, K-BERT, HUBERT, and more : TinyBERT, ALBERT, DistilBERT…

Quelle variante est réellement utilisée chez Google : franchement, c’est impossible à dire et c’est en réalité sans importance dès lors que l’on comprend que tous ces outils reposent sur les mêmes principes, et que ce qui change est assez marginal.

SMITH, une autre variante de BERT

Or voila qu’un expert SEO américain, Roger Monti découvre un outil du nom de SMITH, et se met derrière à se dire : tiens, un papier scientifique est sorti sur un nouvel algo, et quelques semaines après, il y’a une grosse update de Google.

Conclusion de cet « expert » : SMITH est en fait à l’origine des chamboulements sur les SERPs observés lors de la dernière update.

Il publie donc un article qui, en dépit de nombreux avertissements sur le fait qu’il n’est pas sûr, que rien ne le confirme etc., suggère quand même au lecteur qu’il est possible que SMITH soit derrière la Core Update de Décembre.

Notons que cet expert n’a pas été tout à fait le premier à faire ce rapprochement hasardeux, les premières spéculations à ce sujet se trouvent dans un thread de Blackhatworld :

https://www.blackhatworld.com/seo/ranking-going-down-there-is-any-google-update.1295739/

Mais son raisonnement est faux à plusieurs niveaux

- SMITH n’est pas vraiment nouveau : c’est juste un nouvel avatar de BERT, capable de travailler sur une fenêtre de texte un peu plus importante que les versions utilisées jusqu’ici. Ce qui est un progrès technique qui bénéficiera certainement à certaines applications.

- Rien ne dit que SMITH est utilisé par l’algorithme de classement de Google et que ce sera vrai un jour : par exemple, il s’est écoulé 7 longues années entre le papier scientifique sur les Word Embeddings et la date de déploiement de Rankbrain qui exploitait ces avancées. 7 ans !

- Et il est inutile de faire appel à SMITH pour expliquer les changements sur cette update (un bon coup de Rasoir d’Occkham fait toujours du bien de temps en temps)

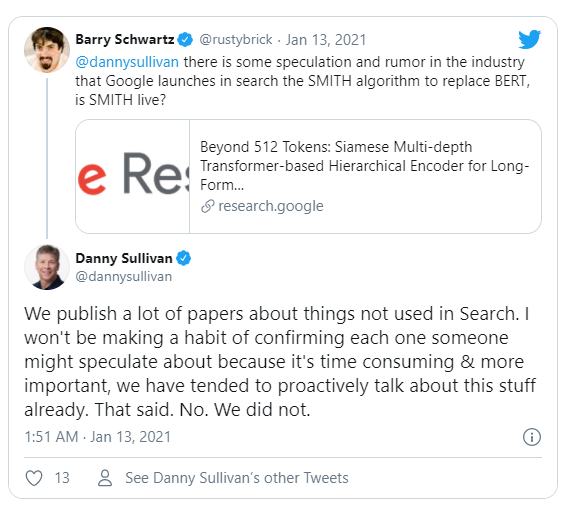

De toute façon, Danny Sullivan a confirmé que SMITH n’était pas utilisé aujourd’hui :

Bref, non, SMITH n’est pas à l’oeuvre derrière la Core Update de Décembre, et c’est dangereux de laisser supposer que ce serait ne serait-ce que « possible », comme le fait Roger Monti.

L’article de Roger Monti :

https://www.searchenginejournal.com/google-smith-algorithm/391929/

et le papier sur SMITH (intéressant, mais sans intérêt immédiat pour le SEO)

https://research.google/pubs/pub49617/

Ce contenu vous a plu ?

Inscrivez-vous gratuitement à notre newsletter et recevez chaque semaine l’actualité du SEO directement dans votre boîte email. Vous pouvez vous désabonner à tout moment !