Définition de X-Robots-Tag :

Il existe plusieurs façons de désindexer un document des moteurs de recherche. La manière la moins connue est peut-être la directive X-Robots-Tag, pourtant bien utile, notamment pour les documents autres que HTML…

Lorsqu’un document (page web, document PDF, Word ou autre) transite sur le Web entre un serveur et un navigateur, il est toujours accompagné d’un en-tête HTTP, où se trouvent notamment les codes bien connus : 404 (Page not found), 301, 302 (redirections) ou 200 si tout est OK.

Dans cet en-tête, il est également possible d’intégrer une directive appelé X-Robots-Tag, qui pourra contenir plusieurs informations qui seront lues par le robot du moteur (par exemple Googlebot) pour lui donner plusieurs directives :

- X-Robots-Tag: noindex (ne pas indexer le document) ;

- X-Robots-Tag: noarchive (ne pas mettre en cache) ;

- X-Robots-Tag: unavailable_after: 25 Jun 2010 15:00:00 PST (indication d’une date de fin de validité du contenu) ;

- X-Robots-Tag: nosnippet (ne pas afficher de résumé pour cette page dans les résultats de recherche) ;

- X-Robots-Tag: notranslate (ne pas proposer la traduction de cette page dans les résultats de recherche) ;

- X-Robots-Tag: noimageindex (ne pas indexer les images de cette page) ;

- X-Robots-Tag: googlebot: nofollow (indication au robot Googlebot de ne pas suivre les liens de la page) ;

- X-Robots-Tag: otherbot: noindex, nofollow (les autres robots ne devront ni indexer la page, ni en suivre les liens) ;

- Etc.

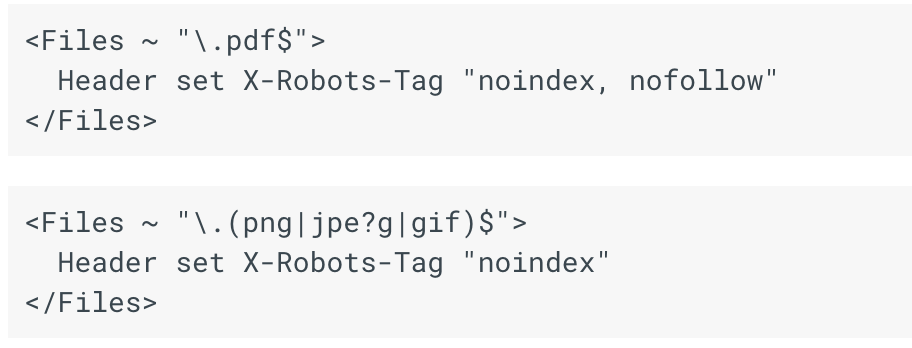

Cette directive se définit par exemple dans le fichier .htaccess sur les serveurs Apache. Elle peut être très utile lorsqu’on veut désindexer des fichiers disponibles à un format autre qu’HTML : Word, Excel, Powerpoint, XML, etc. et qui n’intègrent pas de balise HTML comme la meta « robots », etc. Et/ou lorsque l’utilisation du fichier robots.txt s’avère complexe.

Deux exemples de définition de directives X-Robots-tag dans le fichier .htaccess d’un serveur Apache. Source : Google. |

Voici également quelques liens pour aller plus loin sur le sujet :

- Caractéristiques de l’en-tête HTTP « X-Robots-Tag » et de la balise Meta pour les robots » (Google)

- En-tête HTTP X-Robots-Tag (Robots-txt.org)

- Les en-têtes HTTP ou comment maîtriser son indexation sur Google (Yapadequoi.com)

- SEO Campus : Indexation et désindexation (Abondance)

Et deux vidéos sur les principes de la désindexation :

Faut-il (dés)indexer les fichiers PDF ? (Abondance)

Should I disallow Googlebot from crawling slower pages? (Google, Matt Cutts)

Ce contenu vous a plu ?

Inscrivez-vous gratuitement à notre newsletter et recevez chaque semaine l’actualité du SEO directement dans votre boîte email. Vous pouvez vous désabonner à tout moment !

Bonjour

Vos infos sont très intéressantes.

J’ai quand même une question

mon blog n’est pas indexé par Google parce que je lis : indexation non autorisée : noindex détecté dans l’en-tête HTTP X Robots Tag

j’ai dû faire une mauvaise manip parce que justement je cherche à indexer mon blog

Pouvez-vous m’indiquer comment faire ?

Merci et bonne journée

Hélène Hénon